728x90

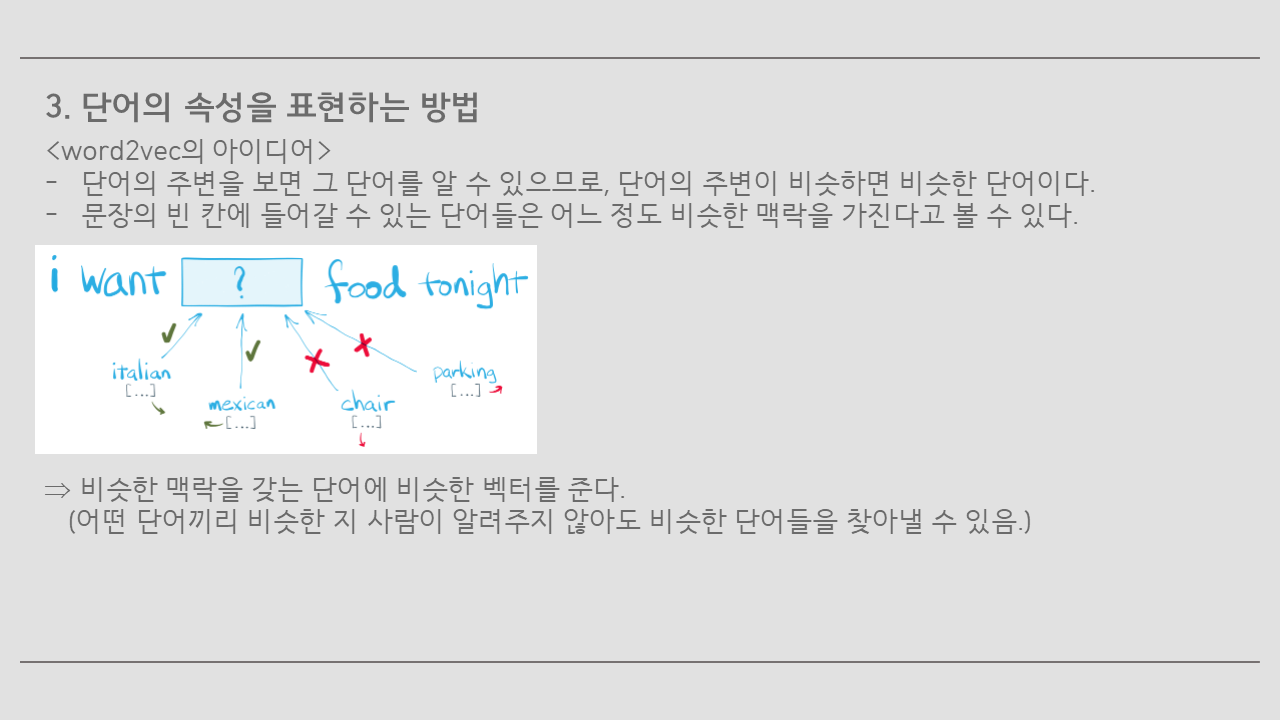

단어의 연관도를 분석하는 인공지능을 탐색하던 중 Word2Vec라는 알고리즘을 발견하여 공부해보았다.

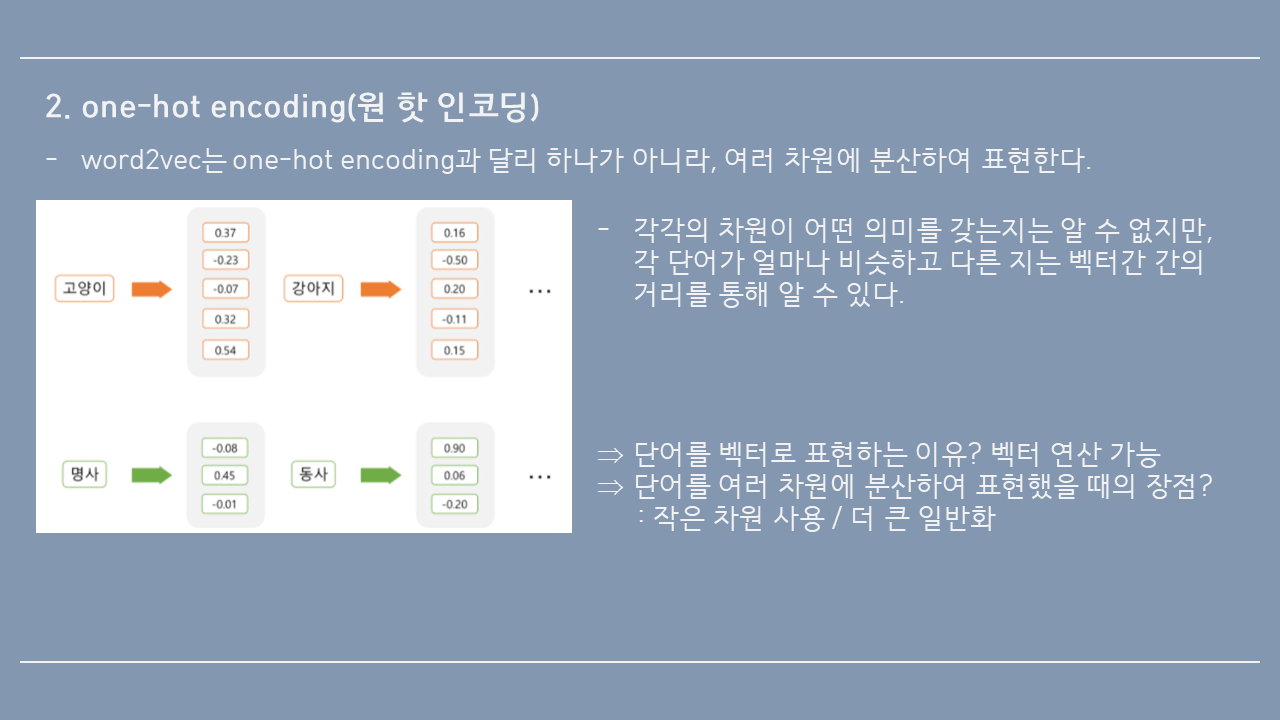

단어를 벡터로 표현하면, 벡터 연산이 가능해진다. 벡터 연산을 하면 앞에서 봤던 것처럼 ‘king – man + woman = queen’이라는 연산이 가능해진다. (단, 벡터가 단어의 의미를 잘 표현하고 있을 경우에 가능)

- 단어를 여러 차원에 분산하여 표현했을 때의 장점

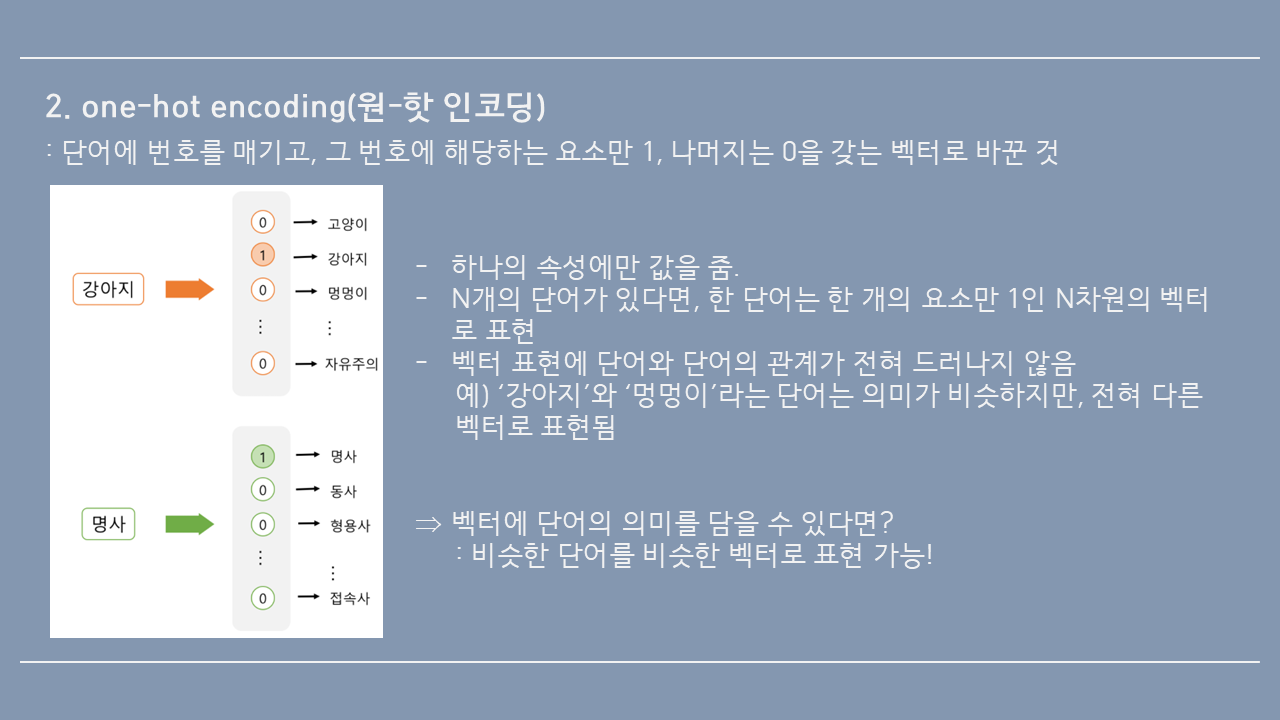

1) 적은 차원으로 대상을 표현할 수 있다. 원핫인코딩처럼 표현하면 단어의 수만큼 차원을 사용하지만, word2vec처럼 표현하면 차원의 크기를 설정하여 거기에 맞춰서 벡터가 표현된다. 보통 20~200차원 정도 사용.

2) 입력 데이터에 0이 많으면 데이터에서 정보를 뽑아내기 어렵지만, 각각의 차원이 모두 정보를 가지고 있으면 모델이 더 작동하기 쉬워진다.

3) 더 큰 일반화 능력을 가지고 있다. 예: 강아지와 멍멍이가 비슷한 벡터로 표현된다면, 강아지에 대한 정보가 멍멍이에서도 일반화될 수 있음. 강아지라는 입력에 애완동물이라는 출력을 하도록 학습이 된다면, 멍멍이라는 입력에서도 비슷한 출력이 나올 가능성이 높다.

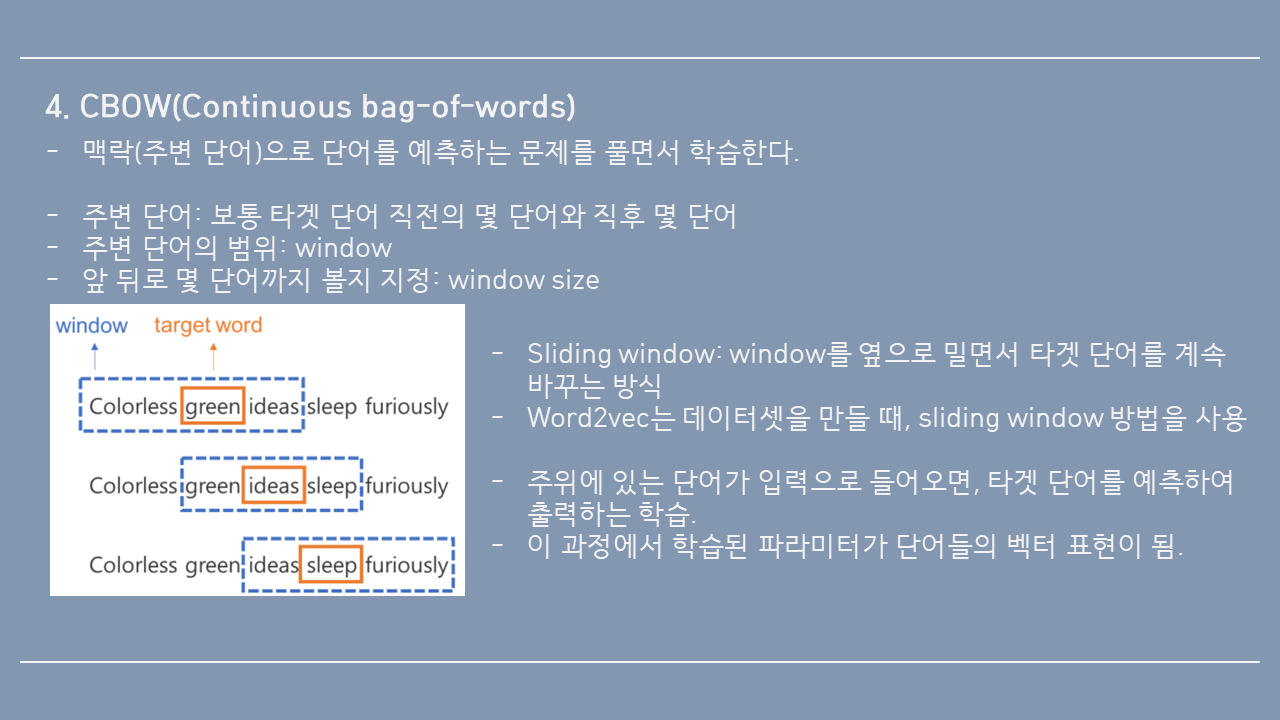

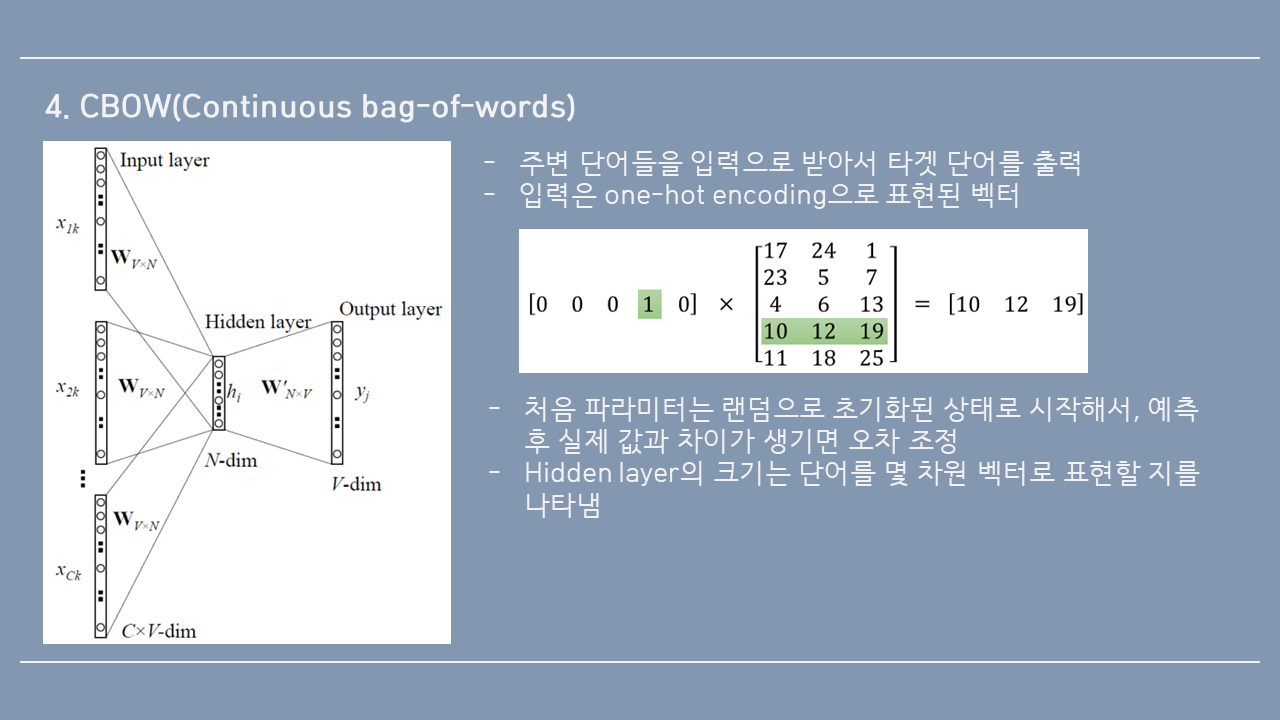

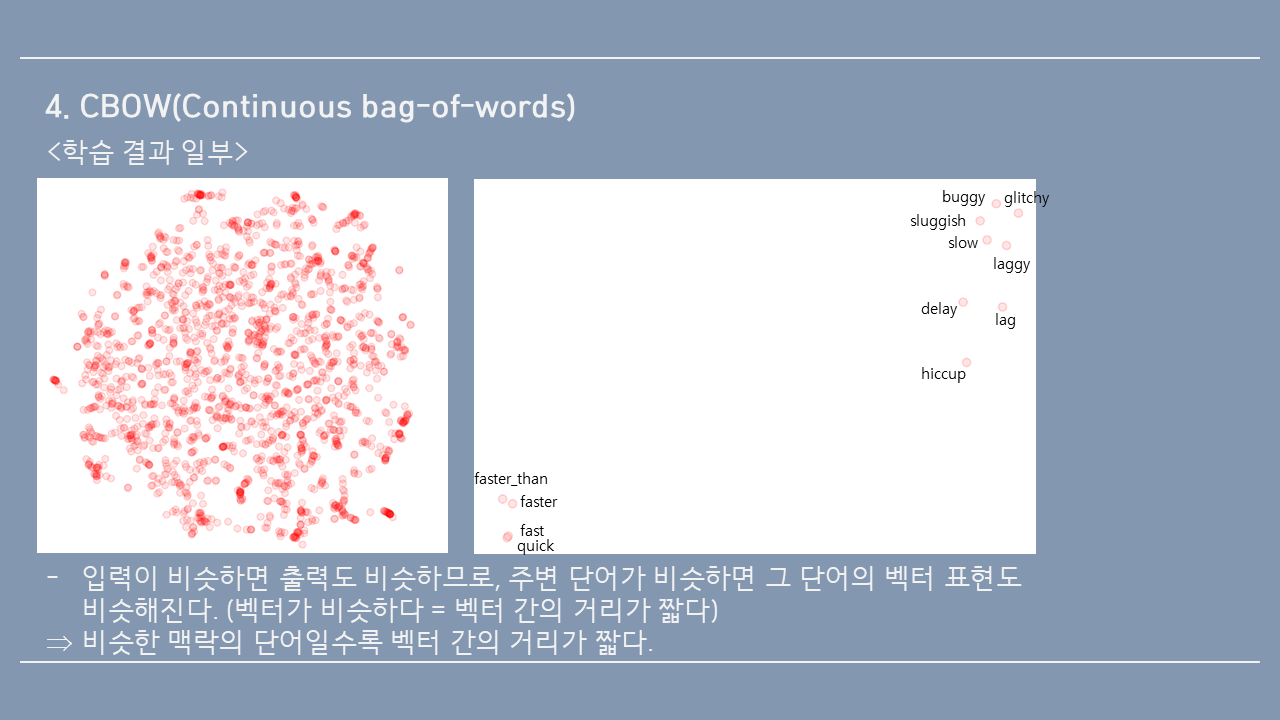

이 내용을 word2vec 방식 중 하나인 CBOW(Continuous bag-of-words)로 자세히 설명해보겠다.

이렇게 만들어진 window 하나하나가 학습데이터가 된다.

728x90

'MI Lab > Word2Vec - 2021.11~2022.01' 카테고리의 다른 글

| [단어 연관도 - Lab meeting] CBOW와 skip-gram - 2021.12.06.월 (0) | 2021.12.27 |

|---|---|

| [단어 연관도 - Lab meeting] Skip-gram 활용 사례 - 2021.11.29.월 (0) | 2021.12.27 |

| [단어 연관도 - Lab meeting] 영단어 추천 사례 - 2021.11.08.월 (0) | 2021.12.27 |

| [단어 연관도 - Lab meeting] 연구 과제 변경 - 2021.11.01.월 (0) | 2021.12.27 |

| [단어 연관도 분석] Word2Vec > skip-gram (0) | 2021.12.05 |